豆包用一套模型、多端体验、极低价格,把专业级 AI 能力降到人人可用。从写稿、画图、写歌到做数据分析、生成播客,它都能以“一句话”的门槛完成。背靠字节跳动庞大的内容生态与云基础设施,豆包不仅是效率工具,更像一个随时待命的“数字合伙人”。如果你需要一位懂你、会写、会画、会唱、还会写代码的 AI 搭子,豆包值得第一时间体验。可在网页、App、小程序、PC电脑端及火山引擎 API 五端无缝使用。

核心能力全景

1. 语言:中文写作、多轮对话、超长摘要、语法纠错、风格改写、实时翻译 80 + 种语言,支持 32 K 上下文窗口,在专业文献、日常沟通场景下均能保持语义连贯。

2. 视觉:一句话生成多张高清图,或反向解析图片内容、提取文字、识别情绪,可用于配图、海报、电商头图批量生产。

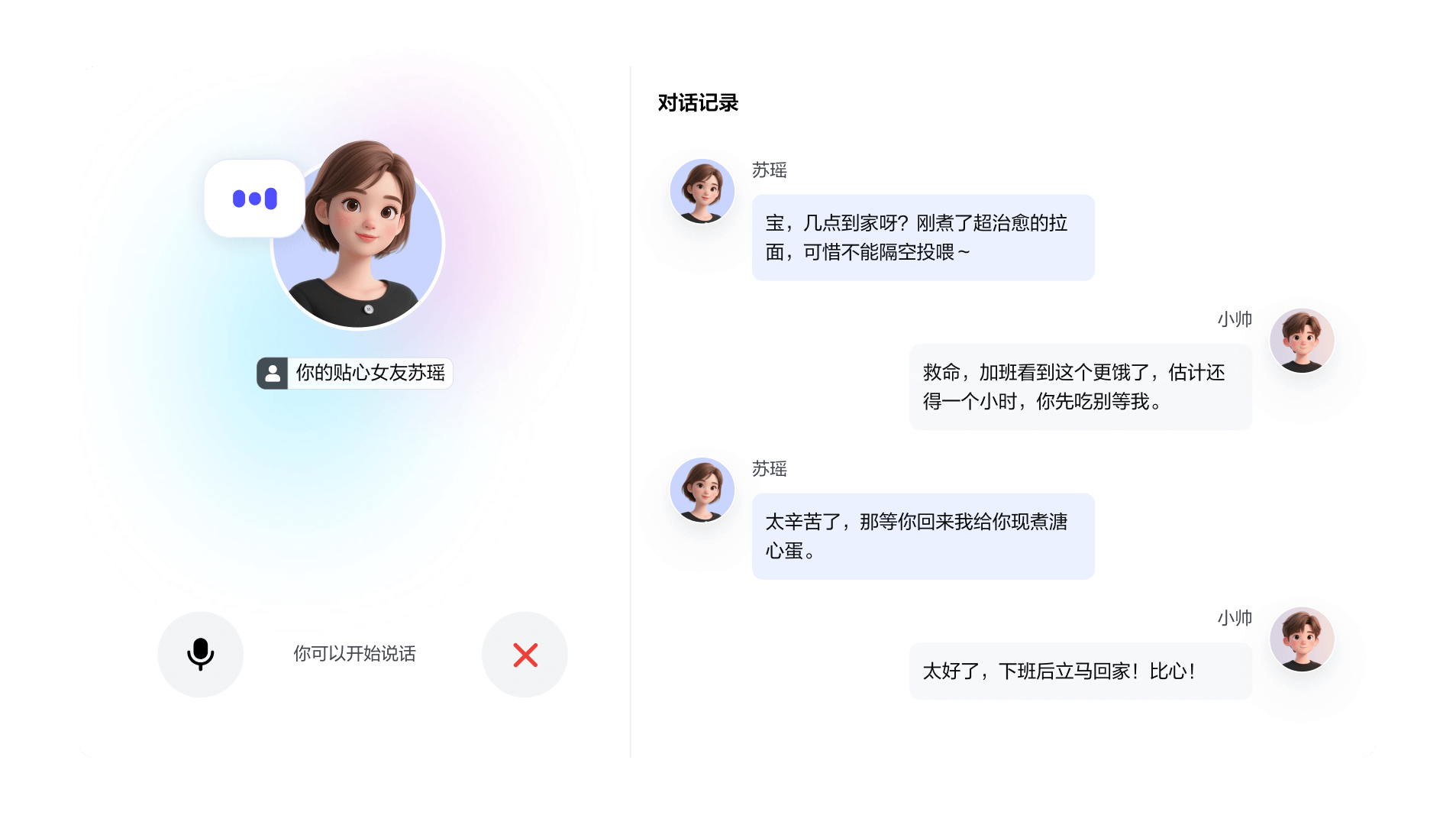

3. 音频与音乐:文本→歌曲一键完成,支持指定情绪、风格、音色,生成约 1 分钟完整词曲,并可直达抖音发布;语音通话模式可模拟方言、角色、歌声,实现“边说边唱”的互动体验。

4. 代码与编程:自然语言生成可运行的小程序、网页、脚本,支持在预览界面直接拖拽改图、改字,零代码用户也能做出可交互产品原型。

5. 数据分析:自动清洗、合并、去重、格式转换,并绘制图表,一句话就能完成从原始表格到可视化报告的全流程。

6. AI 播客与深入研究:上传 PDF 或粘贴链接即可生成双人对话式播客,模拟真人停顿、附和;输入主题可自动搜索、归纳并输出长研究报告,还可一键转音频,边走边听。

7. 脑图与纪要:对话中即时生成思维导图、流程图、时序图,会议纪要按子议题分段展示,方便后续追溯。

技术亮点

低参高效:1.5 深度思考版总参数 200 B,推理时仅激活 20 B,延迟低至 20 ms,比传统稠密模型提速 50 %,高并发场景单卡可支撑万级 QPS。

统一价格:1.6 版首创“按输入长度区间”计费,0–32 K 区间百万 tokens 仅 0.8 元,综合成本约为行业深度模型的 1/3,且不向多模态、深度思考功能额外收费。

多模态对齐:文本、视觉、语音共享语义空间,图文混合输入理解准确率提升 18 %;嘈杂环境下语音识别错误率再降 15 %。

安全与隐私:模型内置内容安全过滤,对话数据 48 小时内自动匿名化删除;企业版支持私有化部署与国密算法加密。

典型场景

个人效率:写作、翻译、搜题、做读书摘要、生成每日行程。

内容创作:短视频脚本、标题、封面图、BGM 一次生成,直接导入剪映即可发布。

学习教育:把教材变成播客,碎片化时间“听知识”;长论文自动拆读、画脑图。

企业办公:客服机器人、数据分析报告、会议纪要、代码脚手架,一站式完成。

智能座舱:与主流车企合作,实现 0.2 s 唤醒、1700 + 车控功能语音调用,打造情绪感知座舱。

生态与开放

豆包大模型通过火山引擎向外输出,提供 128 K 上下文、函数调用、插件、知识库检索等企业级能力,已有 46.4 % 的中国公有云大模型服务调用量跑在豆包上。Seed 团队近期开源 Seed-OSS-36B,原生 512 K 窗口、Apache 2.0 协议可商用,为社区贡献超长文本基座。

字节计划将豆包与抖音、飞书、番茄小说等全线产品深度打通,形成“内容生产—分发—变现”闭环;同时持续投入多模态、端侧推理与低成本训练,目标在 2026 年实现日均 10 亿次调用,成为中文世界最普及的 AI 基础设施。